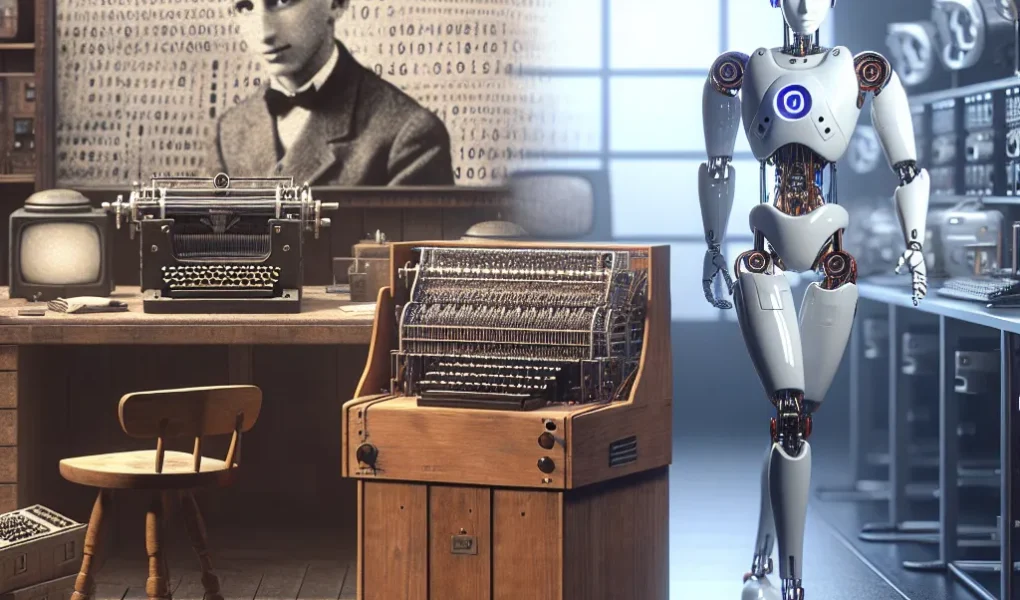

Początki informatyki: maszyny liczące i pierwsze komputery

Początki informatyki sięgają czasów, gdy pierwsze maszyny liczące miały na celu ułatwienie wykonywania skomplikowanych obliczeń matematycznych. Jednym z najważniejszych wynalazków uznawanych za protoplastę dzisiejszych komputerów była maszyna analityczna zaprojektowana przez Charlesa Babbage’a w XIX wieku. Choć nigdy nie została w pełni zbudowana za jego życia, koncepcja tej mechanicznej maszyny do obliczeń z wbudowaną pamięcią oraz możliwością programowania uważana jest za fundamentalny krok w kierunku rozwoju komputerów. Kolejnym istotnym etapem był rozwój maszyn elektromechanicznych, takich jak maszyna licząca Z3 skonstruowana przez Konrada Zusego w 1941 roku, która uznawana jest za pierwszy działający komputer programowalny.

W okresie II wojny światowej powstały inne przełomowe urządzenia, m.in. ENIAC (Electronic Numerical Integrator and Computer), którego budowa została ukończona w 1945 roku. Był to pierwszy ogólnego przeznaczenia elektroniczny komputer, zdolny do wykonywania ponad pięciu tysięcy operacji arytmetycznych na sekundę. Choć jego wielkość była imponująca – zajmował całe pomieszczenie i ważył około 30 ton – ENIAC zapoczątkował nową erę w rozwoju techniki cyfrowej. Takie osiągnięcia technologiczne stanowiły solidne fundamenty pod dalszą ewolucję komputerów oraz rozwój dziedziny, jaką dzisiaj nazywamy informatyką.

Maszyny liczące i pierwsze komputery stanowiły zatem kluczowy element w historii rozwoju technologii informacyjnej. Ich ewolucja była napędzana zarówno przez potrzeby naukowe, jak i militarne, przyczyniając się do powstania nowoczesnych systemów obliczeniowych, które stanowią podstawę dzisiejszej cyfrowej rzeczywistości. Początki informatyki pokazują, jak od prostych mechanizmów służących do liczenia przeszliśmy do złożonych procesów, które umożliwiają rozwój takich technologii jak sztuczna inteligencja.

Rewolucja mikroprocesorowa i narodziny komputerów osobistych

Rewolucja mikroprocesorowa, która rozpoczęła się w latach 70. XX wieku, stanowi jeden z kluczowych momentów w historii rozwoju technologii komputerowej. Wcześniejsze generacje komputerów opierały się na złożonych układach scalonych i zajmowały całe pokoje, co czyniło je niedostępnymi dla przeciętnego użytkownika. Przełomem okazało się wynalezienie mikroprocesora – układu scalonego, który integrował funkcje centralnej jednostki przetwarzającej (CPU) w jednym, kompaktowym chipie. Mikroprocesor Intel 4004 zaprezentowany w 1971 roku był pierwszym tego typu układem i zapoczątkował lawinowy rozwój komputerów osobistych.

Wraz z mikroprocesorem pojawiła się możliwość tworzenia coraz mniejszych, tańszych i bardziej dostępnych urządzeń. To właśnie mikroprocesory były fundamentem dla narodzin komputerów osobistych, które zrewolucjonizowały sposób, w jaki ludzie pracują, uczą się i komunikują. Przełomowym momentem było pojawienie się komputera Apple I w 1976 roku, a następnie Apple II i IBM PC, które wprowadziły komputery na masowy rynek i na stałe zagościły w biurach oraz domach.

Mikroprocesory nie tylko zmieniły rozmiar i koszt komputerów, ale także zapoczątkowały dynamiczny rozwój oprogramowania i systemów operacyjnych, tworząc podłoże pod współczesny przemysł IT. Narodziny komputerów osobistych były kluczowym krokiem w kierunku cyfrowej transformacji społeczeństwa i dały początek obecnej erze informacyjnej. Rewolucja mikroprocesorowa stanowiła fundament, na którym rozwinął się świat komputerów, a później – sztucznej inteligencji.

Era sztucznej inteligencji: komputery uczą się myśleć

Era sztucznej inteligencji to przełomowy moment w ewolucji komputerów, kiedy to maszyny przestały być jedynie narzędziami do obliczania, a zaczęły symulować procesy poznawcze charakterystyczne dla ludzkiego myślenia. Rozwój sztucznej inteligencji (AI) umożliwił komputerom uczenie się na podstawie danych, rozumienie języka naturalnego, a nawet podejmowanie decyzji w oparciu o analizę wzorców i predykcję. Dzięki takim technologiom jak uczenie maszynowe (machine learning), głębokie uczenie (deep learning) oraz przetwarzanie języka naturalnego (NLP), komputery zyskały zdolność nie tylko do szybkiego przetwarzania informacji, ale również do samodzielnego nabywania wiedzy i adaptowania się do nowych sytuacji.

Dzisiejsze systemy sztucznej inteligencji są wykorzystywane w wielu dziedzinach życia – od medycyny, przez motoryzację, aż po finanse czy edukację. Przykładem są chociażby autonomiczne pojazdy, które uczą się reagować na otoczenie, chatboty odpowiadające na skomplikowane pytania użytkowników czy asystenci głosowi, którzy rozumieją i przetwarzają mowę. Wprowadzenie inteligentnych algorytmów do codziennego użytku zmieniło sposób, w jaki korzystamy z komputerów i internetu. Coraz częściej nie tylko przetwarzamy dane, ale pozwalamy maszynom je analizować, wyciągać wnioski i proponować rozwiązania.

W kontekście ewolucji komputerów, era sztucznej inteligencji to znaczący krok naprzód – od logicznie zaprogramowanych maszyn do systemów zdolnych do myślenia i uczenia się. Zastosowanie AI sprawia, że komputery stają się coraz bardziej autonomiczne, a jednocześnie złożone technologicznie. To nie tylko nowy etap w historii rozwoju technologii, ale także początek redefinicji relacji człowieka z maszyną – gdzie komputer staje się partnerem intelektualnym, a nie tylko narzędziem obsługiwanym przez człowieka.